이번에 졸업작품으로 딥러닝 과제를 진행 중이였는데 짱 멋지신 박은종 멘토님께서 마침 좋은 기회를 만들어 주셔서 gpu서버를 할당받았다. 다음 모집은 7월이라고 하니 관련된 정보를 알고싶으면 아래 블로그에서 확인해보자! 아직 자리가 조금 남아있어서 추가로 모집하고 계신 것 같기도 하다!

처음에 서버에 딱 들어가니 완전 깡통상태였다. 그래서 하나하나 직접 설치해 주었다. 급하게 이것저것 설치하다보니 기억은 안나지만 아래와 같은 것들을 설치했다.

apt update

apt install git tmux pip python htop

C

복사

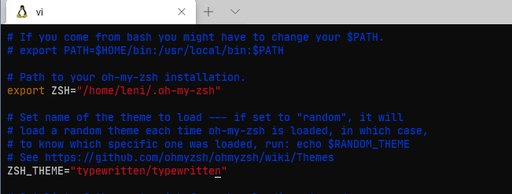

zsh 환경이 편해서 zsh환경설정과 몇몇 플러그인들을 설치해주었다. 아래 블로그에 잘 정리되어 있으니 참고하자! 나는 auto-suggestion과 syntax-highliting 정도만 설치하였다.

그런데 이제 개발환경 세팅을 다 마치고 학습을 위한 학습데이터를 옮기려고 보니 100GB가 넘는 파일을 어떻게 넘길지 고민되었다. 우선 내 로컬에 파일이 있으니 ftp프로토콜을 활용해 보기로 했다.

sftp로 파일 옮기기 ...

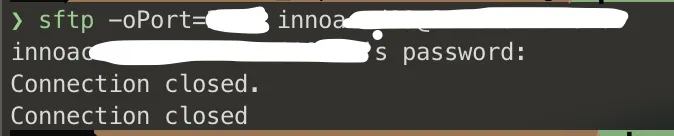

로컬에 파일이 있으니 sftp 프로토콜을 활용해서 파일을 옮겨보려고 시도했다. 그런데 서버에서 요청을 거절하는지 Connection closed가 되면서 계속 정상적인 연결이 되지 않았다. 아무래도 ssh접속은 열려있으나 서버측에서 sftp 프로토콜을 허용하지 않는 모양이다.

우선 나는 급한 상황이기 때문에 다른 방법을 찾아보았다. 다행이도 구글 드라이브에 파일을 옮긴 후, 해당 파일을 다운로드 받는 방법을 찾아내었다.

linux 환경에서 구글 드라이브로 대용량 파일 다운받기

문제는 파일이 너무 대용량이라는 건데 마침 나와 비슷한 고민을 겪은 천재 개발자가 멋진 모듈을 만들어 두었다. 사용법도 매우 간단했다.

설치

pip install gdown

# to upgrade

pip install --upgrade gdown

C

복사

사용

gdown https://drive.google.com/uc?id=<file_id> # for files

gdown <file_id> # alternative format

gdown --folder https://drive.google.com/drive/folders/<file_id> # for folders

gdown --folder --id <file_id> # this format works for folders too

Shell

복사

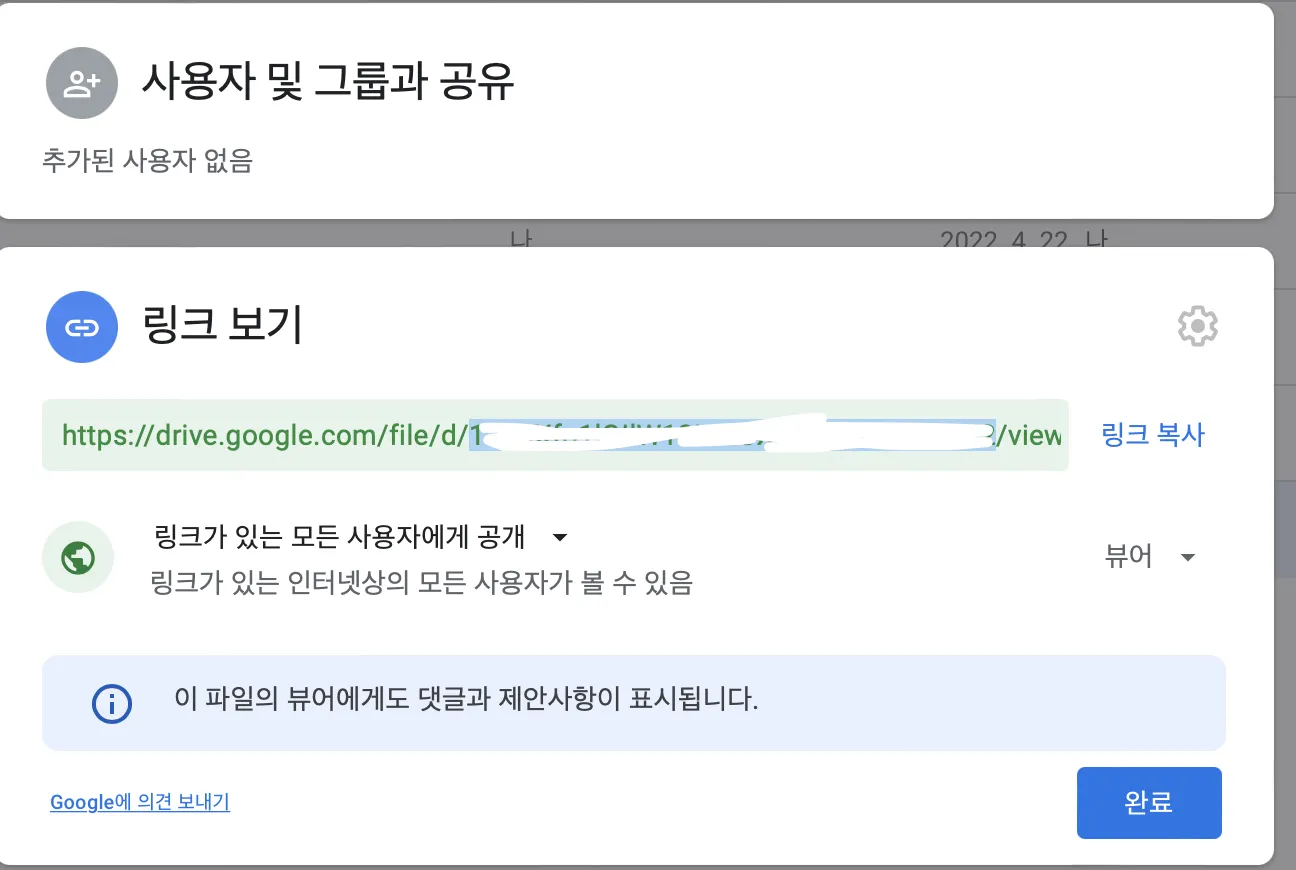

여기서 file_id는 다운로드 하려는 파일의 링크를 생성하면 얻을 수 있다. 흰색으로 가려진 부분을 가져오면 된다. 이제 대용량 파일을 다운로드 받기만 하면 끝이다!

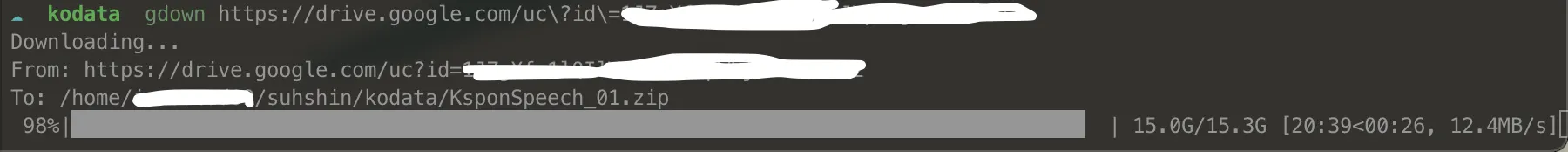

하나당 15G가 넘는 파일도 쉽게 받을 수 있다!